작성자: sonslab | 발행일: 2025년 5월 5일

들어가며: 디지털 두뇌의 사고방식 진화

우리가 만든 디지털 두뇌는 인간과 같은 방식으로 '생각'할까요? 아니면 전혀 다른 방식으로 세상을 해석하고 있을까요?

이 질문은 단순한 궁금증을 넘어 철학적, 기술적, 그리고 실용적 차원에서 우리 시대의 핵심 화두입니다. 인공지능 연구자들은 70년 이상 '지능'의 본질을 이해하고 모방하려 노력해왔습니다. 그 과정에서 가장 큰 변화는 아마도 AI가 '생각'하는 방식에 대한 우리의 관점 전환일 것입니다.

이전 시리즈에서 인공지능의 정의와 범주, 인공지능의 역사적 발전 단계, 약한 AI와 강한 AI의 구분, 튜링 테스트와 AI의 철학적 의미, 그리고 초기 연구 접근법과 AI 겨울기에 대해 다뤘습니다. 이번 글에서는 현대 AI 발전의 핵심 변곡점, 즉 '규칙 기반'에서 '데이터 중심'으로의 패러다임 전환을 살펴보겠습니다. 이 변화는 단순한 기술의 발전을 넘어, 인간이 지능과 학습의 본질을 새롭게 성찰하게 만든 사상적 전환점이었습니다.

"세상의 모든 지식을 규칙으로 담을 수 있을까?"

1970-80년대 인공지능 연구는 심볼릭 AI(Symbolic AI)라 불리는 패러다임에 지배되었습니다. 이 접근법은 논리적 규칙과 지식 표현에 기반했습니다. 이 시기의 AI 연구자들은 지식을 명시적인 규칙과 논리적 표현으로 코딩하면 컴퓨터가 인간처럼 추론할 수 있을 것이라고 믿었습니다.

전문가 시스템: 규칙 기반 접근법의 황금기

MYCIN, DENDRAL, PROSPECTOR와 같은 전문가 시스템은 특정 분야의 전문가 지식을 IF-THEN 규칙으로 코딩했습니다. 이러한 시스템은 실제로 일부 전문 영역에서 인상적인 성과를 거두었습니다.

예를 들어, 스탠포드 대학에서 개발한 의학 진단 시스템 MYCIN은 다음과 같은 규칙을 사용했습니다

IF 환자가 고열이 있고

AND 환자의 혈액 배양에서 세균이 발견되며

AND 환자가 최근 수술을 받았다면

THEN 패혈증 가능성이 높다(0.8)

DENDRAL은 질량 분석 데이터를 사용하여 유기 분자의 구조를 결정했고, PROSPECTOR는 지질학적 데이터를 기반으로 광물 매장지를 예측했습니다. 이 시스템들은 각 분야의 전문가들과 비슷한 수준의 판단을 내릴 수 있었고, 특히 MYCIN은 일부 평가에서 인간 의사보다 더 정확한 감염병 진단을 내리기도 했습니다.

지식 표현의 도전과 한계

지식 공학(Knowledge Engineering)이라 불리는 이 접근법은 처음에 큰 기대를 모았으나 곧 근본적인 한계에 부딪혔습니다. MIT AI 연구소의 마빈 민스키가 지적했듯, "컴퓨터에게 세상의 지식을 가르치는 일은 백과사전을 작성하는 것보다 어렵다"는 사실이 분명해졌습니다.

상식의 역설(Common Sense Paradox): 인간에게 가장 자연스러운 일상적 상식이 기계에게는 가장 코딩하기 어려운 것이었습니다. "우산은 비를 막는 데 사용한다"와 같은 당연한 지식을 형식화하는 작업은 예상보다 훨씬 복잡했습니다. 이는 암묵적 지식(tacit knowledge)의 문제와 연결됩니다. 인간은 말로 표현하지 않고도 자연스럽게 알고 있는 것들이 많지만, 컴퓨터에게는 모든 것을 명시적으로 알려줘야 했습니다.

확장성 문제(Scalability Issue): 규칙 시스템이 더 많은 지식을 다룰수록 규칙 간 상호작용은 기하급수적으로 늘어났고, 시스템은 점점 느려지고 관리하기 어려워졌습니다. MYCIN은 약 600개의 규칙으로 구성되었지만, 더 복잡한 분야를 다루려면 수만, 수십만 개의 규칙이 필요했습니다. 더글라스 레나트의 Cyc 프로젝트는 1984년부터 시작해 수백만 개의 상식 규칙을 코딩했지만, 여전히 인간 수준의 상식 추론에 도달하지 못했습니다.

프레임 문제(Frame Problem): 현실 세계의 상황을 표현할 때 무엇이 중요하고 무엇이 중요하지 않은지 결정하는 문제는 놀라울 정도로 어려웠습니다. 어떤 행동이 주변 환경의 어떤 측면을 변화시키고 어떤 측면은 그대로 유지하는지 모든 경우를 고려하는 것은 사실상 불가능했습니다.

불확실성 처리의 한계(Limitations in Handling Uncertainty): 규칙 기반 시스템은 확실한 지식과 명확한 추론에 적합했지만, 실제 세계의 불확실성과 모호함을 다루는 데 어려움을 겪었습니다. 확률과 통계적 추론을 통합하려는 시도가 있었지만(베이지안 네트워크 등), 기본적인 패러다임의 한계를 완전히 극복하지는 못했습니다.

이러한 한계들은 단순한 구현 문제가 아니라 접근 방식 자체의 근본적인 한계를 드러냈습니다. 결국 AI 연구자들은 새로운 방향을 모색하기 시작했습니다.

"규칙을 만들지 말고, 패턴을 찾게 하자"

1990년대와 2000년대 초반, AI 연구의 중심은 '머신러닝'이라는 새로운 접근법으로 서서히 이동했습니다. 핵심 아이디어는 간단했습니다: "시스템에 명시적인 규칙을 가르치는 대신, 데이터에서 패턴을 찾도록 학습시키자."

머신러닝: 경험에서 배우는 AI

이 접근법의 선구자 중 한 명인 토머스 미첼은 1997년 머신러닝을 다음과 같이 정의했습니다: "컴퓨터 프로그램이 경험 E로부터 학습해 작업 T에 대한 성능 측정 P를 향상시킨다면, 그 프로그램은 학습한다고 할 수 있다."

이 정의는 머신러닝의 본질을 잘 포착합니다. 인간 프로그래머가 모든 규칙을 직접 코딩하는 대신, 컴퓨터가 '경험'(즉, 데이터)에서 스스로 학습할 수 있게 하는 것입니다. 이는 인간 아이가 명시적인 규칙을 배우기보다 경험과 관찰을 통해 많은 것을 학습하는 방식과 유사합니다.

초기의 머신러닝 접근법에는 결정 트리(Decision Trees), 나이브 베이즈 분류기(Naive Bayes Classifiers), 서포트 벡터 머신(Support Vector Machines), k-최근접 이웃(k-Nearest Neighbors) 알고리즘 등이 포함됩니다. 이러한 알고리즘들은 패턴 인식, 분류, 회귀 분석 등의 작업에서 인상적인 성과를 보여주었습니다.

통계적 자연어 처리의 성공

이 패러다임 전환의 초기 성공 사례 중 하나는 자연어 처리(NLP) 분야에서 나타났습니다. IBM의 연구팀은 1990년대에 기계 번역에 대한 혁신적인 접근법을 도입했습니다. 그들은 언어학적 규칙을 코딩하는 대신, 영어와 프랑스어로 된 캐나다 의회 기록과 같은 대량의 병렬 텍스트를 사용하여 통계적 번역 모델을 훈련시켰습니다.

IBM의 피터 브라운은 당시 "우리는 프랑스어를 모르지만, 2천만 개의 문장이 있다면 번역기를 만들 수 있다"고 말했습니다. 이는 지식을 직접 코딩하지 않고도 데이터에서 패턴을 찾아 학습할 수 있다는 패러다임 전환의 핵심을 잘 보여줍니다.

패러다임 전환의 철학적 의미

이 패러다임 전환은 다음과 같은 근본적인 변화를 가져왔습니다:

지식의 명시적 코딩에서 암시적 학습으로(From Explicit Coding to Implicit Learning): 시스템은 더 이상 사람들이 직접 코딩한 규칙에 의존하지 않고, 데이터에서 스스로 패턴을 발견했습니다. 이는 "컴퓨터가 스스로 배울 수 있는가?"라는 오랜 질문에 긍정적인 답을 제시했습니다.

논리적 추론에서 통계적 추론으로(From Logical to Statistical Inference): AI 시스템은 확실성보다 확률에 기반해 작동하기 시작했습니다. 이는 불확실성과 노이즈가 많은 실제 세계에서 더 효과적이었습니다. 베이지안 확률론과 통계적 학습 이론이 중요한 이론적 기반이 되었습니다.

전문가 지식에서 데이터 기반 지식으로(From Expert Knowledge to Data-Driven Knowledge): 시스템의 성능은 인간 전문가의 규칙보다 양질의 데이터와 효과적인 학습 알고리즘에 더 의존하게 되었습니다. 이는 "지식의 민주화"를 가져왔습니다. 특정 전문가의 지식보다 집단적으로 생성된 데이터가 더 중요해졌기 때문입니다.

연역적 접근에서 귀납적 접근으로(From Deductive to Inductive Approach): 전통적인 AI는 일반적인 규칙에서 특정 결론을 도출하는 연역적 추론에 의존했습니다. 반면 데이터 중심 접근법은 특정 사례들에서 일반적인 패턴을 발견하는 귀납적 추론에 더 가깝습니다.

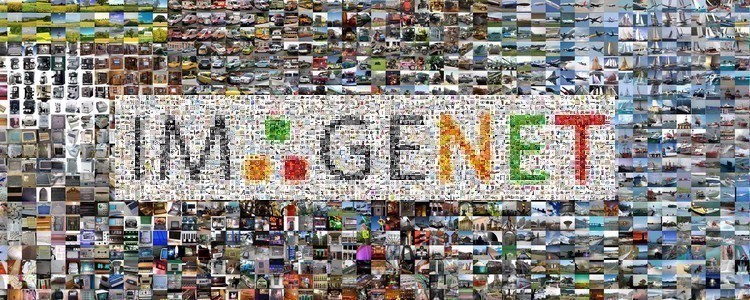

이미지넷 모멘트: 딥러닝 혁명의 시작

2012년은 AI 역사에서 결정적인 전환점이 된 해입니다. 토론토 대학의 제프리 힌튼과 그의 학생들(Alex Krizhevsky, Ilya Sutskever)이 개발한 AlexNet이라는 합성곱 신경망(CNN)이 이미지넷 대회에서 기존 기술보다 월등히 뛰어난 성능을 보였습니다.

딥러닝의 폭발적 성장

이미지넷 대회(ImageNet Large Scale Visual Recognition Challenge)는 컴퓨터 비전 분야의 주요 경쟁이었습니다. 참가자들은 1,000개의 다른 범주로 이미지를 분류하는 알고리즘을 개발해야 했습니다. 2011년까지 최고의 오류율은 약 26%였습니다. 그러나 2012년 AlexNet은 오류율을 16.4%로 낮추었습니다. 이는 당시로서는 혁명적인 발전이었습니다.

이 사건은 종종 '이미지넷 모멘트(ImageNet Moment)'라고 불리며, 이후 딥러닝 붐의 시작을 알렸습니다. 몇 년 동안 묻혀 있던 신경망 기술이 갑자기 AI 연구의 중심으로 돌아왔습니다.

AlexNet의 성공 이후, 신경망 구조는 더욱 깊고 복잡해졌습니다. VGGNet, GoogLeNet, ResNet 등의 아키텍처가 등장하면서 이미지 인식 성능은 계속 향상되었습니다. 특히 ResNet(Residual Network)은 '스킵 연결(skip connections)'이라는 혁신적인 기법을 도입해 수백 개의 층을 가진 네트워크를 효과적으로 훈련할 수 있게 했습니다.

알고리즘에서 데이터로: "모든 데이터는 지식이다"

데이터 중심 패러다임의 또 다른 중요한 측면은 알고리즘보다 데이터의 중요성이 커졌다는 점입니다. 구글의 연구 디렉터였던 피터 노르빅은 이런 통찰을 공유했습니다: "더 나은 알고리즘보다 더 많은 데이터가 때로는 더 효과적입니다."

데이터의 양과 질이 성능을 좌우한다

이러한 관점 변화는 2001년 마이크로소프트 연구소의 논문 "The Unreasonable Effectiveness of Data"에서 잘 표현되었습니다. 연구자들은 간단한 알고리즘이라도 충분한 데이터가 있으면 놀라운 성능을 보일 수 있다는 것을 보여주었습니다.

실제로 구글의 번역 시스템은 복잡한 언어학적 규칙보다 수십억 개의 문장 쌍으로 훈련된 상대적으로 단순한 통계적 모델에 의존했습니다. 이 시스템은 직접적인 언어학적 지식 없이도 놀라운 번역 능력을 보여주었습니다.

데이터 수집과 관리의 중요성 증가

이 관점은 AI 개발의 초점을 바꾸었습니다:

알고리즘 엔지니어링에서 데이터 엔지니어링으로(From Algorithm Engineering to Data Engineering): 연구자들은 더 정교한 알고리즘을 개발하는 대신, 더 나은 데이터셋을 구축하는 데 집중하기 시작했습니다. 데이터 수집, 정제, 레이블링, 증강이 핵심 역량이 되었습니다.

전문가 설계에서 데이터 큐레이션으로(From Expert Design to Data Curation): AI 시스템의 품질은 알고리즘 설계자의 전문성보다 훈련 데이터의 품질과 다양성에 더 의존하게 되었습니다. 편향되지 않고 다양한 데이터셋을 구축하는 것이 중요한 도전 과제가 되었습니다.

도메인 지식의 재평가(Reevaluation of Domain Knowledge): 도메인 지식은 여전히 중요했지만, 이제 알고리즘 설계보다 데이터 수집과 특성 엔지니어링에 더 적용되었습니다. 전문가들은 알고리즘을 코딩하는 대신 좋은 데이터를 식별하고 레이블링하는 데 더 많은 시간을 투자하게 되었습니다.

데이터 중심 AI의 변화하는 인프라

이러한 패러다임 변화는 AI 인프라에도 영향을 미쳤습니다. 기업들은 크고 복잡한 데이터셋을 수집, 저장, 처리하기 위한 시스템을 구축하기 시작했습니다. 구글의 MapReduce, 아파치 하둡(Apache Hadoop)과 스파크(Spark)와 같은 빅데이터 프레임워크가 AI 인프라의 핵심 요소가 되었습니다.

이러한 패러다임 변화는 2024년 현재까지도 계속되고 있으며, 특히 엣지 AI 기술의 발전으로 AI 처리 방식에 또 다른 변화가 일어나고 있습니다. 중앙화된 데이터센터에서의 처리에서 데이터가 생성되는 네트워크 엣지로 인텔리전스가 이동하고 있습니다. 이는 자율 주행 자동차, 스마트 기기, 산업용 IoT 장치 등에서 실시간 의사 결정이 중요한 응용 분야에서 특히 중요합니다.

생성 AI: 데이터 중심 패러다임의 절정

현재 우리가 목격하고 있는 ChatGPT, 미드저니, DALL-E와 같은 생성 AI 시스템의 폭발적 발전은 데이터 중심 패러다임의 정점을 보여줍니다. 이 시스템들은 방대한 양의 텍스트, 이미지, 코드로부터 학습하여 새로운 콘텐츠를 창조합니다.

스탠포드 대학의 2024년 AI 인덱스 보고서에 따르면, 현대 AI는 이미지 분류, 시각적 추론, 영어 이해 등 여러 벤치마크에서 인간의 성능을 초과했으며, 산업계가 학계보다 더 많은 주목할 만한 모델을 생산하고 있습니다.

이러한 발전은 데이터 중심 접근법의 강력함을 입증하지만, 동시에 새로운 질문과 도전을 제기합니다:

설명 가능성과 투명성: 대규모 신경망은 종종 '블랙박스'로 여겨집니다. 결정 과정을 설명하고 이해하기 어렵습니다.

데이터 품질과 편향: 훈련 데이터의 품질과 다양성은 AI 시스템의 공정성과 정확성에 직접적인 영향을 미칩니다.

계산 비용과 환경 영향: 최첨단 AI 모델 훈련 비용이 전례 없는 수준에 도달했습니다. 예를 들어, OpenAI의 GPT-4는 훈련에 약 7800만 달러의 컴퓨팅 자원을 사용했습니다. 이는 환경적, 경제적 지속가능성 문제를 제기합니다.

하이브리드 접근법: 패러다임의 융합

흥미롭게도, 규칙 기반과 데이터 중심 접근법은 상호 배타적이지 않습니다. 최근 연구는 두 패러다임의 장점을 결합하는 하이브리드 방식을 탐색하고 있습니다:

신경-상징적 AI(Neuro-Symbolic AI): 이 접근법은 신경망의 패턴 인식 능력과 기호적 추론의 해석 가능성을 결합합니다.

지식 증강 학습: 외부 지식 소스를 사용하여 순수 데이터 기반 학습을 보완하는 방법입니다.

검색 증강 생성(RAG): 2024년에는 개발자가 서비스형 RAG와 같은 AI 마이크로서비스를 통해 상용 AI 모델을 커스터마이징함에 따라 소프트웨어 개발 키트와 API의 수준이 높아지고 있습니다. 이는 기업이 최신 비즈니스 정보에 액세스할 수 있는 지능형 시스템을 구축하는 데 큰 도움이 되고 있습니다.

인간-AI 협업: 제가 반도체 산업에서 경험하는 바로는, 전자 현미경 이미지 계측에서 AI와 인간 전문가의 협업이 가장 효과적인 결과를 가져옵니다. AI는 패턴을 감지하고, 인간은 맥락을 이해하고 최종 판단을 내립니다.

인간 중심 AI로의 전환: 패러다임의 다음 단계

데이터 중심 패러다임이 AI 발전을 가속화했지만, 다음 도약을 위해서는 또 다른 변화가 필요합니다. '인간 중심 AI'라는 새로운 패러다임이 부상하고 있으며, 이는 기술적 성능뿐만 아니라 인간의 가치와 필요를 중심에 두는 접근법입니다.

데미스 허사비스 구글 딥마인드 CEO는 "뇌의 움직임은 매우 복잡하지만 컴퓨터로 재현하지 못할 것은 없다"고 말하면서도, 많은 기업이 AI를 사용한다고 말하지만 90%는 그 의미를 제대로 이해하지 못한다고 지적합니다.

인간 중심 AI 패러다임은 다음과 같은 원칙을 강조합니다:

윤리와 책임: 스탠포드 AI 인덱스 보고서에 따르면, AI 책임성에 대한 견고하고 표준화된 평가가 심각하게 부족한 상황이며, 이는 최고 AI 모델의 위험성과 한계를 체계적으로 비교하는 노력을 복잡하게 만들고 있습니다.

투명성과 설명 가능성: 복잡한 AI 시스템의 결정 과정을 이해하고 해석할 수 있어야 합니다.

포용성과 접근성: AI 기술과 그 혜택은 모든 사람, 모든 지역에 공평하게 분배되어야 합니다.

지속가능성: AI 시스템의 환경적, 사회적, 경제적 영향을 고려해야 합니다.

디지털 시대의 새로운 패러다임에 관한 최근 연구에 따르면, 현대 사회를 지배하는 인공지능 기술은 인간의 개인화 욕구를 충족시키는 것으로 보이지만 더욱 중앙집중화된 형태를 낳고 있다고 합니다. 이러한 착시현상을 이해하기 위해서는 현대 사회를 이해하고 미래를 설계할 수 있는 리터러시 능력을 배양해야 한다고 지적합니다.

앞으로 다른 글에서 인간중심AI에 대해 좀더 심도있게 다뤄 보도록 하겠습니다.

나가며: 인류와 함께 진화하는 AI

지능의 본질에 대한 우리의 이해는 지속적으로 발전하고 있습니다. 규칙 기반에서 데이터 중심으로, 그리고 이제 인간 중심 AI로의 패러다임 전환은 단순한 기술적 진보가 아니라, 인간과 기계의 관계를 재정립하려는 깊은 철학적 성찰을 반영합니다.

인공지능 연구의 초기에는 "기계가 생각할 수 있는가?"라는 질문이 중심이었습니다. 지금은 "기계가 어떻게 생각하는지"뿐만 아니라 "기계가 인간과 어떻게 공존하고 협력할 수 있는지"에 대한 질문으로 확장되었습니다.

처음 질문으로 돌아가 보면, 인공지능은 인간과 같은 방식으로 '생각'하지 않습니다. 그러나 데이터에서 패턴을 찾고, 확률을 계산하고, 경험에서 학습하는 AI의 능력은 인간 지능의 일부 측면을 반영합니다. 궁극적으로, AI는 인간의 확장이자 보완물로서 우리와 함께 공진화하고 있습니다.

물리학자 리처드 파인만은 "내가 그것을 만들 수 없다면, 나는 그것을 이해하지 못한 것이다"라고 말했습니다. AI를 만들고 발전시키는 과정에서, 우리는 지능 자체에 대한 더 깊은 이해를 얻고 있습니다. 그리고 이 여정에서 가장 중요한 것은 기술이 아니라, 그 기술이 인류에게 어떤 의미를 가져오는가 하는 점입니다.

AI의 발전에 따라, 우리는 "AI가 무엇을 할 수 있는가"에서 "AI가 무엇을 해야 하는가"로 초점을 전환하여, 기술의 윤리적 방향성과 사회적 책임을 고민해야 합니다. 이것이 바로 인간 중심 AI 패러다임의 핵심입니다.

인간 중심 AI는 기술이 인간의 결정을 보완하고 강화하며, 인간의 가치와 윤리를 중심에 두고 설계된 인공지능을 의미합니다.

여러분은 어떻게 생각하시나요? AI의 다음 패러다임은 무엇이 될까요? 그리고 그것은 우리의 삶과 일을 어떻게 변화시킬까요?

Sonslab은 현재 반도체 MI 분야에서 엔지니어들에게 AI 기술을 활용하여 전자 현미경 이미지를 계측 분석하는 플랫폼을 개발하고 있습니다. 2024년 DDCON에서 "자동화 시대의 AI와 인간의 협업 시너지" 주제로 강연을 진행했으며, 인간 중심 AI 기술과, 응용 Application 개발에 관심을 가지고 관련 도서를 준비 중입니다.

'1. AI의 기본 개념과 역사' 카테고리의 다른 글

| 딥러닝의 부상과 신경망의 재조명: 침체에서 혁명으로 (2) | 2025.05.06 |

|---|---|

| AI 겨울과 르네상스 시기의 교훈: 기대와 실망의 역사적 순환 (0) | 2025.04.26 |

| 논리의 언어로 기계를 깨우다: 초기 AI 연구의 주요 접근법 (0) | 2025.04.22 |

| 튜링 테스트와 AI의 철학적 의미: 기계는 생각할 수 있는가? (0) | 2025.04.21 |

| 약한 인공지능과 강한 인공지능의 구분: 의식을 가진 기계는 가능할까? (1) | 2025.04.20 |